日前,2024世界机器人大会在京举办。诺亦腾联合创始人、CTO戴若犁博士受邀出席大会专题论坛「人机融合:共创具身智能机器人新时代青年精英论坛」,发表主题演讲《用动作捕捉技术构建具身智能数据工厂》。

“自去年下半年以来,诺亦腾动作捕捉产品在机器人领域中的销售比例大幅增加,这一变化促使我们深入机器人行业进行研究,发现这一领域对于高质量人类动作数据的需求正在急速增加。”

“自去年下半年以来,诺亦腾动作捕捉产品在机器人领域中的销售比例大幅增加,这一变化促使我们深入机器人行业进行研究,发现这一领域对于高质量人类动作数据的需求正在急速增加。”

在演讲中,戴博士从动作捕捉技术与具身智能机器人领域的关系切入,分享了他的洞察与见解。他详细阐述了诺亦腾具身智能机器人解决方案的工作流程,强调人体与机器人本体之间的映射在整体工作流程之中的重要性与挑战性;阐释四种主流机器人数据集生产方式的差异,并最终通过介绍诺亦腾与行业内合作伙伴的落地案例,再次强调建立大规模具身智能数据工厂(DataFactory)的重要性与可行性。

以下为此次演讲的全文整理。

感谢各位。我是做动作捕捉的,所以先用简单一句话跟大家解释一下什么是动作捕捉。动作捕捉就是用各种技术的手段,把人的动作数字化。人的动作很难变为时间域上面的数字表达,因此需要用到一些复杂的数学方式,通过计算机视觉、各种传感器的方式,把人的动作数字化。

那动作捕捉为何和机器人,或者说人形机器人相关呢?先简单介绍一下我的公司。诺亦腾位于北京,是一家国家级的专精特新小巨人企业。动作捕捉这件事情,其实诺亦腾已经做了十二年了。在过去这十几个年头里,机器人领域其实并不是我们的市场重点。但是从去年下半年开始,这个领域中的合作激增,相关营收数字翻了四倍。有这么多的机器人领域用户与我们合作,去采集高质量的,数字化的人类动作,我们不得不高度重视。

动作捕捉在具身智能领域的

五个应用方向

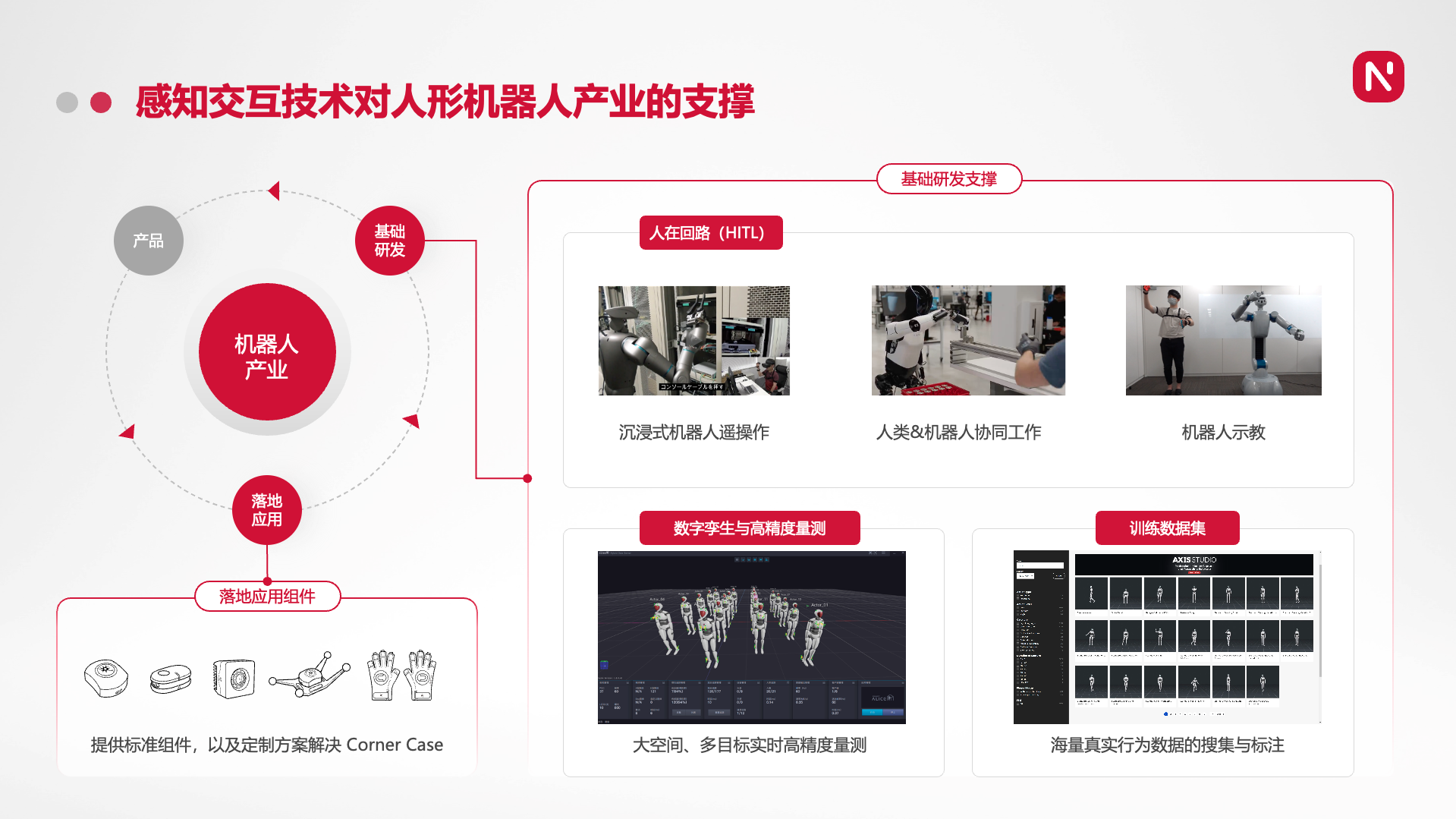

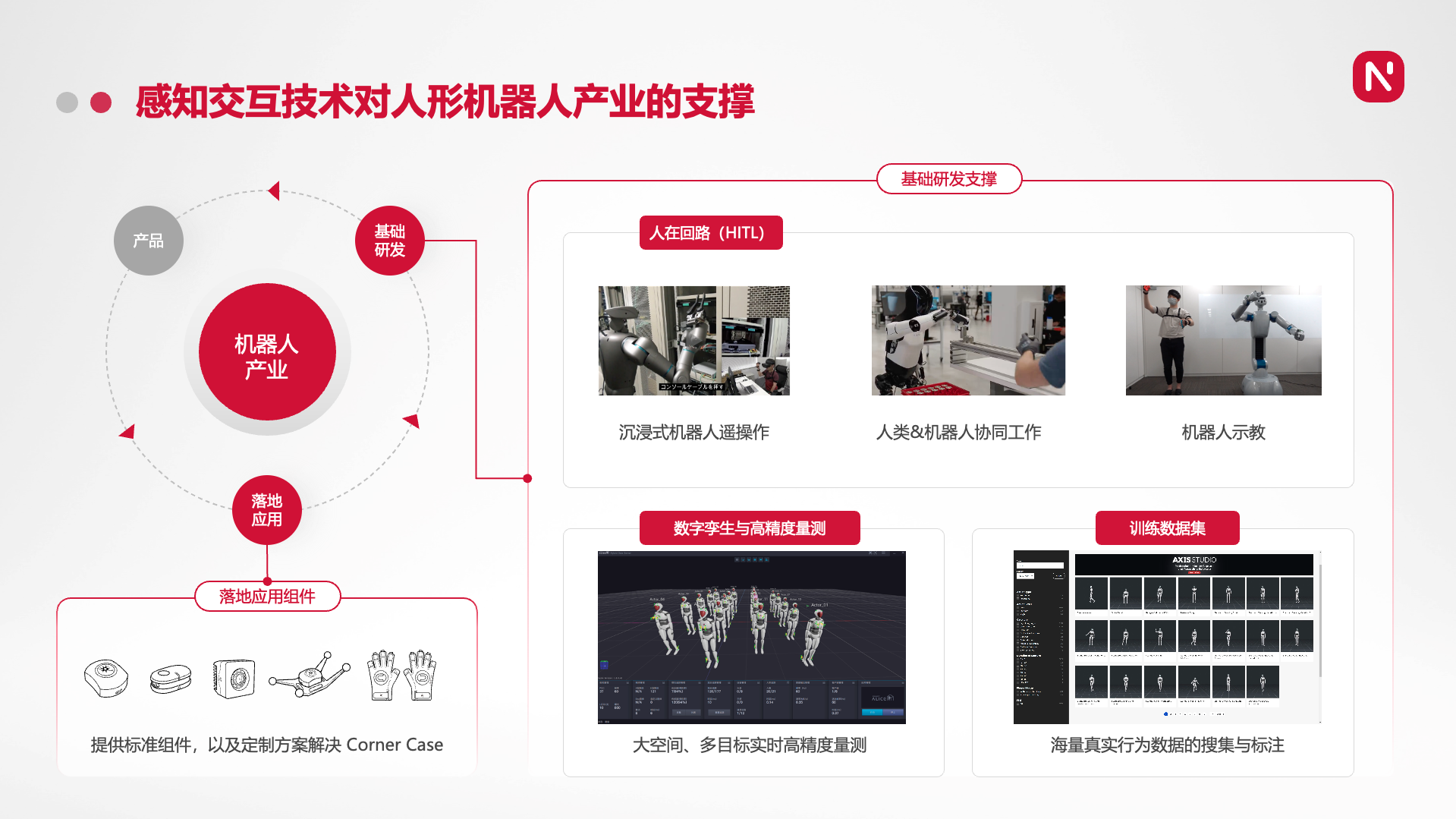

通过对机器人应用领域进行深入调研,我们发现具身智能人形机器人领域的客户,主要在以下五个方向应用诺亦腾的动作捕捉设备。

部分图片源于 robotics.tokyo 以及 www.tesla.com/AI

遥操作(Teleoperation)。人类通过身体/手指来远程控制机器人,还可以通过虚拟现实设备,实现远程存在(Telepresence),更加真实与灵活地操控机器人。在诺亦腾的早期,就有像早稻田大学背景的 TokyoRobotics 这样的公司在利用诺亦腾的动作捕捉设备进行遥操作任务,包括疫情期间的远程巡检、数据中心服务器维护等。甚至还有一家智利的企业利用诺亦腾动捕遥操作机器人在火山口采集样本。

人类-机器人在环境中的协同工作。利用动作捕捉技术,还可以帮助机器人更好地融入人类存在的环境中,和人类共同完成任务,同时对任务的完成情况进行实时监测。

机器人示教。通过人类对机器人进行示范教育,也就是Human Demonstration,在机器人领域中是一种非常成熟有效的方法。人类作出示范动作,通过动作捕捉系统映射到机器人本体并且记录。通过采集大量的人类示教数据去训练机器人,以便在机器人智能尚未成熟时,帮助其学习如何主动执行任务。

大会论坛现场

以上三个方向都属于人在回路(Human-in-the-loop)的范畴。对于具身智能机器人的智能提升来说,是非常重要的。特别是在机器人示教与训练数据采集方向,如果能将这一路径规模化,形成大规模的数据工厂,将会有更大的收益。

数字孪生与高精度量测。这一能力在机器人研发的验证环节至关重要。结构耦合而成的机器人并不是理想的刚性体,它在运动执行任务的过程中会出现一定程度的形变。特别是在大规模训练数据采集流程中,对大空间、多目标进行实时量测,获取机器人的高精度姿态与运动轨迹,将帮助研究人员发现本体存在的问题并及时修正。

训练数据集。最终通过采集海量的真实行为数据,并对其进行标注,将构建起通用的数据集,进一步提升机器人的性能,为机器人训练提供有力的支持。目前来看,通过规模化这一路径是有着非常明确的预期收益的。而诺亦腾作为目前动作捕捉领域中经验突出,参与过丰富项目的厂商,愿意与更多本体厂商展开合作,只有动捕厂商与本体厂商通力合作,才能做到最好。

为何说遥操作

是极为重要的

在这里重点说一下遥操作(Teleoperation)。传统来说,遥操作是为了在恶劣的、人力不可达的环境中去完成一些具体的任务。但是后来我们发现,有越来越多的科研工作者开始利用遥操作去收集数据,并对机器人进行训练。

打个比方来说,包括 Tesla 在内的智能车企业,他们生产的汽车就是遥操作设备,是人类开着一个智能载具在真实环境中完成运载的任务。最终的目标,一定是要达到L5级别的自动驾驶,但是在此之前,要有大量的数据信息作为提升智能的「原材料」,开车的过程其实和遥操作一个智能运载机器人的过程是一致的。

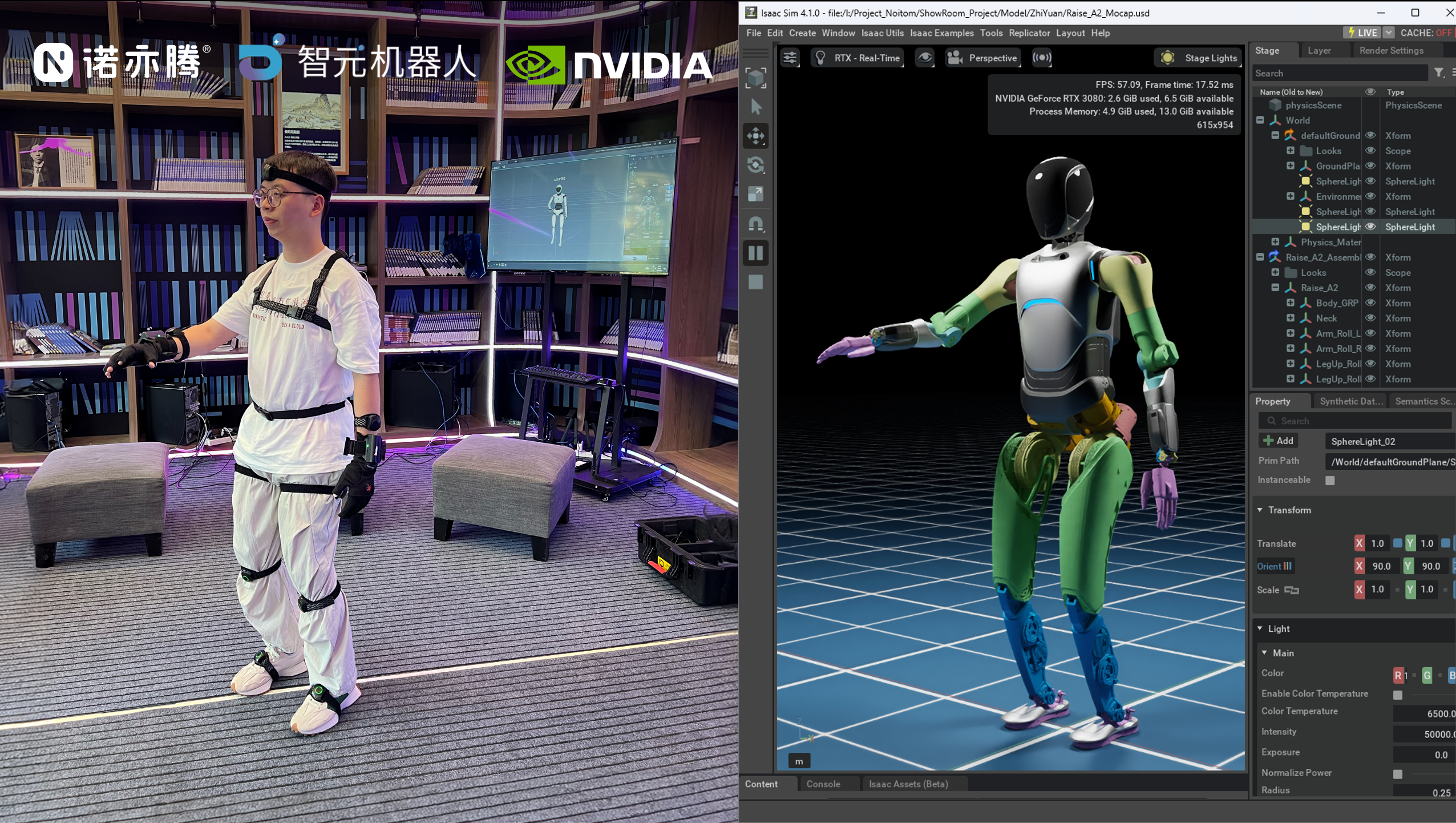

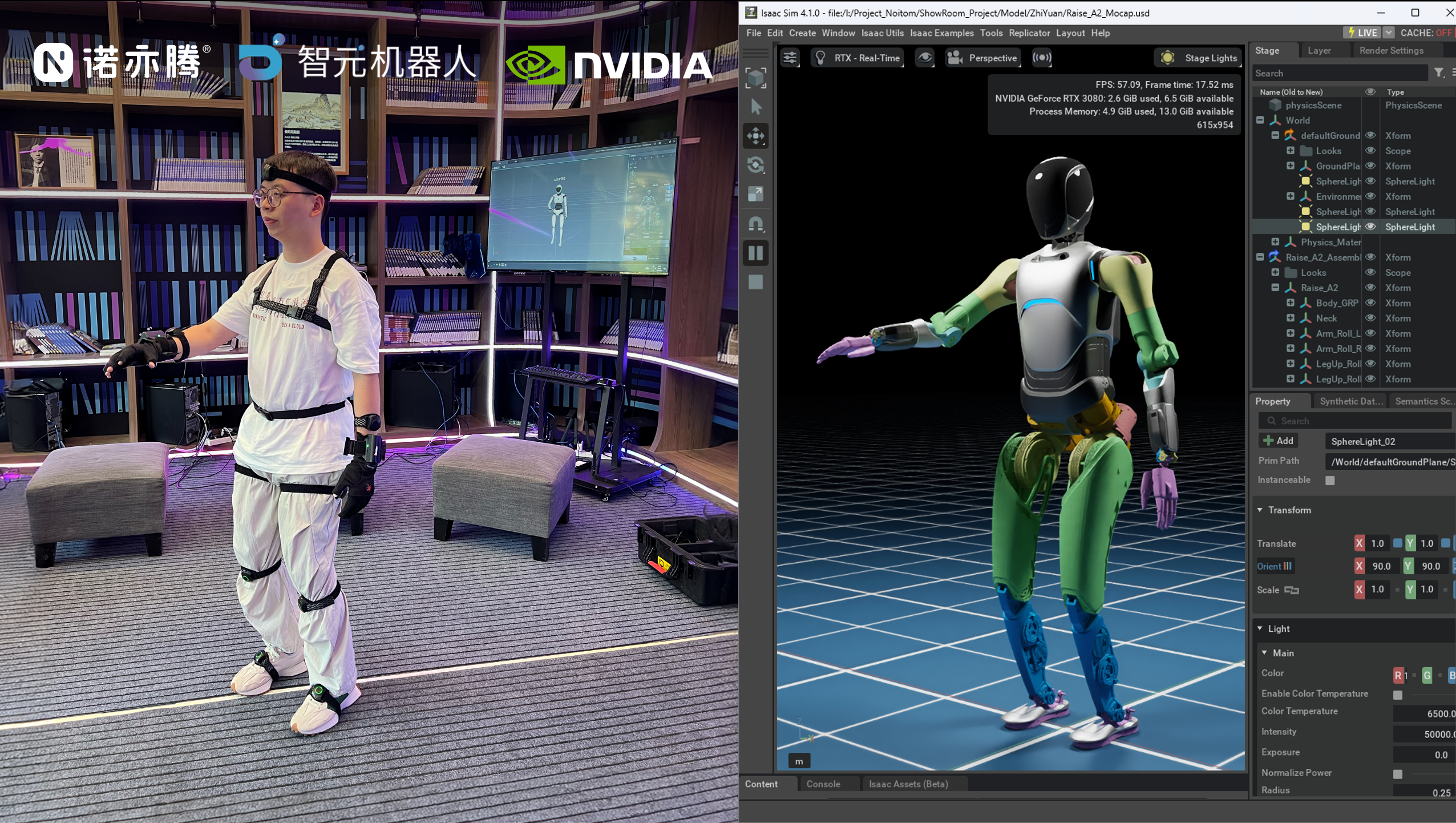

诺亦腾合作伙伴,智元机器人

远征 A2 机器人采用诺亦腾动作捕捉系统进行遥操作控制

在这里再介绍几个合作伙伴的例子:一个是智元机器人,他们利用了诺亦腾的动作捕捉设备去进行机器人的遥操作,共同探索提升算法的「Sim2Real2Sim」路径。我专门和智元研究院的姚卯青姚院长进行过沟通,他表示是非常看好动作捕捉遥操作这条路径的。

智元A2机器人可以通过诺亦腾动作捕捉系统在真实物理世界与虚拟空间中进行遥操作采集数据集,用于训练策略/控制规则(Policy)。经过优化的Policy将被迁移回到真实环境中的本体,实现智能算法的提升。这样的算法优化路径,既能在最大程度上消除 Real2Sim Gap,同时也将 Sim2Real Gap 尽量保留在可控的视觉部分,以获得更佳的训练效果。

“在遥操作流程中,sensing(动作捕捉)和actuating(机器人本体)的厂商需要通力合作,才能把流程做到最顺畅,效果做到最好。动作捕捉系统可以捕捉更多的关节,更丰富的数据,相比需要算法IK逆向解算的其他动作采集方式,更为便利,更为稳定,信息的裕量也更好。动作捕捉系统原生支持灵巧手和全身运动的捕捉,将人形机器人更多应用场景变为可能。”

—— 姚卯青,诺亦腾业界合作伙伴,智元机器人研究院 执行院长

诺亦腾合作伙伴,千寻智能机器人

采用诺亦腾动作捕捉系统进行遥操作控制

另一家厂商是千寻智能,同样在动捕遥操作具身智能机器人这条路上与诺亦腾有非常良好的合作,共同探索高效率,高精度的遥操作流程和数据产出流程。

“过去十年,我曾带队在工业机器人/协作机器人领域量产交付了几十款,超20000台产品,深深敬畏从科研到实用,从样机到产品的巨大鸿沟。同样,诺亦腾在行业里也有十余年的商业化成功经验,全球市场占有率处于领先地位,相信两家‘老司机企业’联手,一定能做好机器人遥操作的产品化落地。”

—— 韩峰涛,诺亦腾业界合作伙伴,千寻智能创始人兼CEO

动作捕捉系统可以捕捉更多的关节,更丰富的数据,相比需要算法IK逆向解算的其他动作采集方式,更为便利,更为稳定,信息的裕量也更好。动作捕捉系统原生支持灵巧手和全身运动的捕捉,可以将人形机器人更多应用场景变为可能。事实上在这次大会上,许多企业也都在他们的研发过程中进行遥操作,在机器人自主性还不满足需求,数据还不充足的情况下,去积累数据。因此这件事情是非常非常重要的。

诺亦腾

如何服务具身智能领域客户?

那么作为一家动作捕捉的厂商,我们是如何服务具身智能人形机器人这个领域中的众多客户的呢?

点击查看大图

首先来说,这个流程从我们自己的子系统开始,也就是动作捕捉。在这个流程图中,我们的 Motion Capture Subsystem 追求的是高精度、低时延、高质量、高频率的人类动作数据采集与记录。

随后的环节,是诺亦腾自己的一套数据处理与输出的闭环,将采集到的原始信息,翻译成为人体的动作数据信息,其中有很多的Know How,但这件事情诺亦腾已经做了12年,服务了各个领域的大小客户,这件事情是我们非常熟悉的了。

有一件往往被许多本体厂商所忽视的事情:人的“本体”和机器人本体,有着本质上的区别。我举个例子:我的肩膀,可以看做是一个有三自由度的球头,但是大部分人形机器人的肩部都是三个结构上分离的单自由度电机。

因此在我们看来,本体映射是这个流程的关键,也是非常困难的。如果直接输出人的动作给到机器人,机器人是学不了的,你要输出和机器人构型一样的自由度,给到和机器人构型一样的位姿的信息,甚至还要有一些包括速度信息在内的其他信息,机器人才能够利用这一信息去进行学习。在我们看来,这一步最合适放在动捕子系统中,由动捕厂商来提供服务。

大会论坛现场

之后还要对工作平台进行适配。只提需求,不匹配执行路径是不行的。作为一个“老”算法工程师,我最敬畏的一点就是从 Paper 到产品之间的这个漫长的路程,其中有大量的工程量,要把它转变成为一个能用、能卖、能维护、能够长期使用不出现错误,鲁棒性足够高的系统,是非常非常困难的。因此需要针对主流的工作平台进行匹配。

在这里值得称道的一家企业是 Nvidia ,他们从很早的时候就开始在具身智能人形机器人这个方向进行投入。因此诺亦腾的解决方案也对这个平台进行了适配。目前这一解决方案所能适配的开发语言、平台包括但不限于 C++ / Python / ROS 以及 Nvidia Isaac。在此之后,才最终来到被驱动的机器人本体以及最终产出的训练数据集。

四种方式

如何生产机器人训练数据集?

最后,我想多用一点时间讲讲机器人的训练数据集的几种生产模式,这是我这次分享的关键内容。

部分图片源于developer.nvidia.com/isaac/sim 等公开平台

现在说到具身智能机器人领域的数据集的生产,一般来说有四种比较清晰的流派。不同的科研工作者可能会选择不同的方向。但是对于业界真正有实力的厂商来说,如果想要真正的落地,实现泛化抓取,完成任务,通常会选择其中两种方法。

基于真实本体的数据集生产方式。比如说 Tesla 就选择了这一方式,我的一些客户厂商也选择了这个方向。真实的人类穿戴动作捕捉设备遥操作一个真实本体,完成真实环境的任务,同时采集这个本体真实的视觉信息、运控信息、传感信息,用来进行训练,这是最高质量的、真实的数据,没有任何 Gap。当然这种方式的成本是最高昂的,一个采集席位就需要一套机器人本体,一套动作捕捉设备,以及一个遥操作采集人员。

诺亦腾 HybridTrack 混合运动测量系统动作捕捉

应用于虚拟本体遥操作

另一种方式是Nvidia等厂商正在力推的一个方向,基于虚拟本体的数据集生产。它的前半截还是真实的,是人类穿戴真实的动作捕捉设备,但是遥操作的对象是一个在物理仿真的虚拟环境中的,和真实本体构型完全一致的虚拟机器人。人类遥操作这个虚拟本体在虚拟环境中完成虚拟任务,同时采集虚拟合成的视觉信息,运控信息以及合成力触觉信息。它的数据质量也是非常高的,因为本体的构型是一致的,而且也确实是真人在进行 Human Demostration,但这种方式多少还是存在着一些 Domain Gap。

图中所示为利用诺亦腾动作捕捉系统遥操作

Nvidia Isaac 平台中的智元远征 A2 机器人虚拟本体

这些方法成本相对高昂,尽管如此,有实力的企业特别是期待早期就能闭环任务执行能落地的企业依然倾向于采用这两种方法(更多的是第一种)来采集数据。追求的还是数据的质量和数据在本体上的兼容性。实际上,主要问题并不是成本,而是效率。效率仍然是数据采集的最大瓶颈。例如,通过遥操作机器人进行任务时,其速度只有真人的五分之一。而第三种方法具有较高的效率。

第三种方式是直接基于人体运动数据的数据集生产。让人类穿戴机器人本体上的那些传感器,也穿戴上动作捕捉设备,让人去完成一个具体的任务。由于这种方式脱离了本体,甚至可以完成一些非常复杂困难的任务,因此效率是非常高的。但是其中存在着巨大的 Human2Robot Gap,甚至要比刚才所说的真实本体与虚拟本体之间的 Gap 还要大,在科研方面的难度是非常非常高的。

大会论坛现场

这种方法依赖于相信「Scaling Law」能弥合所有差距,但目前我对此暂时持怀疑态度。这个假设类似让一个婴儿不允许实操只能看视频学会走路和拼乐高。当然如果这一方法成功实现,将极大降低数据生产成本。我更倾向于相信合成数据和真实数据将以一个合适的比例进行组合,达到质量与成本的平衡。

建设未来极有价值的

具身智能数据工厂

一个成熟的,结合了动作捕捉/高精度追踪子系统、数据处理与输出流程、本体映射工作流以及支持多种平台、本体的解决方案,如果再设计得好,能易于搭建,能高效运转,是能支持建设起来大规模「具身智能数据工厂」的。

诺亦腾携手深圳市人工智能与机器人研究院(AIRS)

筹建大规模数据工厂,本图仅为示意参考

“广东省具身智能机器人创新中心致力于建设国家‘具身智能机器人产业集群的技术型服务平台’,与全球知名的动作捕捉设备厂商诺亦腾开展紧密合作,针对具身智能机器人训练数据集生产等行业共性需求进行技术攻关,致力打造行业标杆性数据工厂范本,推动提升国内的推动提升国内的人工智能与机器人技术水平。”

—— 丁宁,诺亦腾战略合作伙伴,广东省具身智能机器人创新中心主任兼深圳市人工智能与机器人研究院(AIRS) 常务副院长

当然,如何让数据通用,可以跨本体使用这件事情,仍然是值得科研探索的事情,我们也在努力。

刚才许多演讲嘉宾都提到了数据获取难,数据质量差这个问题。目前,诺亦腾正在与一些有远见有见识的机构积极讨论合作,探讨更多可能性,探索集中力量,建设有规模、产能够、成本可控的具身智能数据工厂的可能性,希望将来能多一种模式来更好地服务大家。

谢谢大家。